GANとDCGAN走り書き

@moratorium08

生成モデル

データセットがあたえられる。データセットが従う確率分布を求めよ!

というのが問題。つまり、データを生成するようなモデルを考えたい。

絵が描ける!

大量の画像を学習させることで、その画像から、新しい画像を生成できる。

ネットで見かけたもの

- 2次元イラスト

- 人の顔

- 風景

- 部屋の画像

- 数字

- 家紋

- etc...

Generative Adversarial Nets

arXiv (前半部分だけをかなりざっと)

Introduction

- Deep learningの識別モデルでの成功技術

- 誤差逆伝播、Dropout、ReLU

- 生成モデルにおいては、最尤推定などをするときに生じる、大量の確率計算の推測することやReLUの恩恵を受けることが難しい

なんとかならないか。

Generative Adversarial Nets(GAN)の特徴

生成モデルと識別モデルを敵対させる。これだけ。

以後識別モデルをD(Discriminator)、生成モデルをG(Generator)とする

つまり

- Dは、与えられた入力が生成モデル由来が本物のデータセット由来かを学習

- Gは、Dが間違えるようなデータを生成することを学習

Gはまさにデータセットそっくりなデータを作るようになる

ちょうど偽札を作る人と警察の関係 これを続けていくとイタチごっこ的に学習していく。

Related Work

- Deep Boltzmann Machine

- 尤度最大化が複雑で近似が必要

- Generative Stochastic Networks

- 明示的には尤度を計算しない

- 誤差逆伝播をする

- Variational Auto Encoder

- 二つのネットを持つが片方は近似に使う

Adversarial nets

データ\boldsymbol{x}から、元の確率分布p_gを学習することを目標

まず、二つの多層パーセプトロンを用意する。

一つは、ノイズ\boldsymbol{z}を入力として、G(\boldsymbol{z};\theta_g)をマップ

- Gは、微分可能な関数で、重みとして\theta_gをもつニューラルネット。

もう一つは、D(\boldsymbol{x};\theta_g)として、出力として一つのスカラー値

- これは、データ\boldsymbol{x}が、サンプルデータから来た確率

学習のステップ

Dが\boldsymbol{x}の出所を正しく発見できるような確率を最大化しつつ、同時にGの学習としてlog(1-D(\boldsymbol{z}))を最小化するように学習する。

すなわち、DとGは、価値関数V(G,D)のminmaxゲーム min_{G}max_{D}V(D,G)=\boldsymbol{E}_{\boldsymbol{x}\sim p_{data}{\boldsymbol(x)}}[logD(\boldsymbol{x})] +

\boldsymbol{E}_{\boldsymbol{z}\sim p_z(\boldsymbol{z})}[log(1-D(G(\boldsymbol{z})))]

により最適化する。

問題点

・安定性が低い

そこで CNNの力を借りるという発想が生まれる。

Unsupervised Representation Learning With Deep Convolutional Generative Adversarial Networks

arXiv (全部やります)

Abstract

- 教師あり学習に対しては、CNNは大きな成果

- 教師なし学習に対しても適用

- GもDも対象をよく階層的に捉えることができた

- 学習データは画像の特徴として適用可能

Introduction

GANはあんまり安定しない。この論文では、

- 多くの場合に安定に収束するようなDC-GANの設計

- Discriminatorを画像分類のタスクに使う

- GANの学習を可視化

- Generatorのvectorは簡単な算術操作に対して有意義な性質を持つ

自然な画像生成

パラメトリックなものとノンパラメトリックなものがあるが、主にパラメトリックなものがよい。 パラメトリックな手法としては、

- テクスチャ合成

- 自然なものを作るのは最近になってもあまり成功しない

- Variational Sampling

- ぼける

- GAN

- ノイズがつよいし、理解不能なものになる

- Laplacian Pyramid を使ってもやはり微妙

- RNNやDeconvolutionもある程度成功しているが、実用されていない

CNNを視覚化する

NN自体、ややブラックボックスだが、CNNが畳み込み的な近似を行っていることや、勾配降下は理想的な画像を検査していると示されている

Approach And Model Architecture

CNNでGANを拡張するのは簡単ではないが、できた。

方針の本質は、最新のCNNの手法を適用すること

- Poolingを StrideのあるConvolutionに置き換える

- 畳み込み層の特徴の上(?)にある全結合層を取り除く

- Global Average Poolingがこの例(らしい(よくわからない

- とにかく深いネットワークでは隠れ層で全結合は削除する

- Batch Normalizationを使う

- 全部に適用するのはよくなく、不安定になるため、GのoutputとDのinputには適用しない。

- GeneratorにReLUを使う。ただしoutputはtanh

- DiscriminatorにLeakyReLUを使う

参考

- ReLU

f(x) = max(0, x)

- LeakyReLU f(x) = max(cx, x); (c は0.001みたいな小さい値)

多分職人芸。

Details of Adversarial Training

LSUN, Imagenet-1k, 画像のデータセットで実験

学習については、

- 画像はGeneratorのoutputであるtanhにあうように[-1,1]に正規化

- 128のミニバッチでSGDで学習

- LeakyReLUのleakは0.2に設定

- またOptimizerにAdamを使用。学習率は0.001推奨だが0.0002の方がよかった。またmomentumは0.5がよかった

Empirical Validation Of DCGANs Capabilities

一般に、教師なし学習の能力を測るために、教師なし学習を特徴抽出にして、これらの特徴から学習してみるという手法がある。これで学習したところ、Exemplar CNNにはおよばないものの、良い精度が出ているとわかる。

また他の解析として、StreetView House Numbers(SVHN)を用いても行った。良さそう。

Investigating And Visualizing The Internals Of The Networks

- もしG内にトレーニングデータが保持されているだけだとすると、内部には潜在的に歪んだ形で保持されていることになるはず。

- もしそうでないとすると、画像は何らかの追加と削除が加えられた"良い表現"になっているはず。

二つの点を補間していくと、""意味的に""(つまり見た目上)、連続的に変化している。つまり、データを暗記しているわけではない。

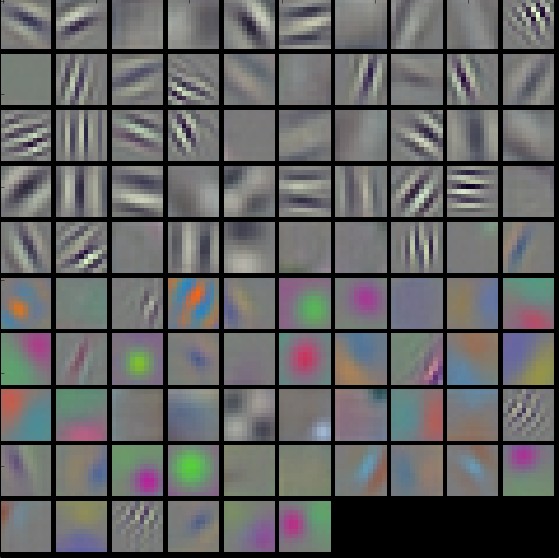

Visualizerの視覚化

CNNにも、各層が特定のパターンにマッチするようになるという話があった。

DCGANにもそれが言えて、Bedroomの画像データセットを使って学習させたところ、特定のパターンにマッチするようなフィルターができた。

ものを描くのを忘れさせる

何らかの表現により主要なBedroomのモノを認識しているはず。窓をわすれさせてみよう。

ロジスティック回帰を使って、2番目に大きな畳み込み層が、窓を表している時には正、関係のないランダムな値を表している時は負の値になるように学習して、ゼロよりかけ離れている値を落とすことで、"窓を忘れさせる"実験をした。

実際別のものに置き換わったり、壁に置き換わったりしている。

顔の算術的表現

Word2Vecでは、 "King" - "Man" + "Woman"を表すベクトル表現のうち、もっとも近いものが"Queen"になるという話があった。 これを画像に適用すると、意味論的に算術計算のようなことができた。

さらに、人間の顔の姿勢についても、左を向いている人と右を向いている人の補間をとると、少しずつ回転した。

Conclusion And Future Work

- まだまだ、発散の問題の解決は必要。

- 映像とか音声にこれらの概念を用いたら面白そう?

言い訳

また実装ができていない・・・・・・・・(駒場祭がなかったらきっとできていたんだって言っている)。

好きな実装